Stochastik

Grundbegriffe der Wahrscheinlichkeitsrechnung

Zufallsexperiment

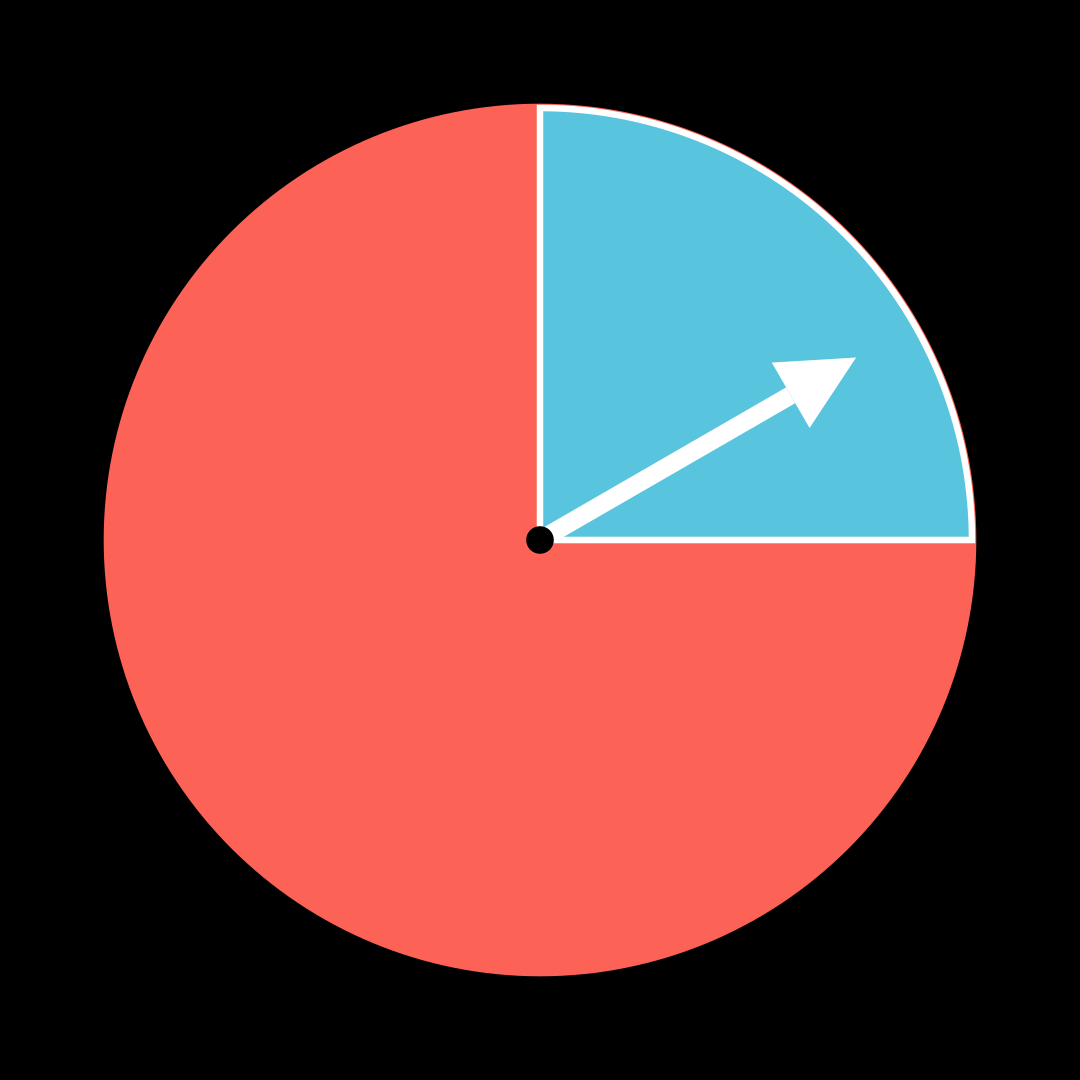

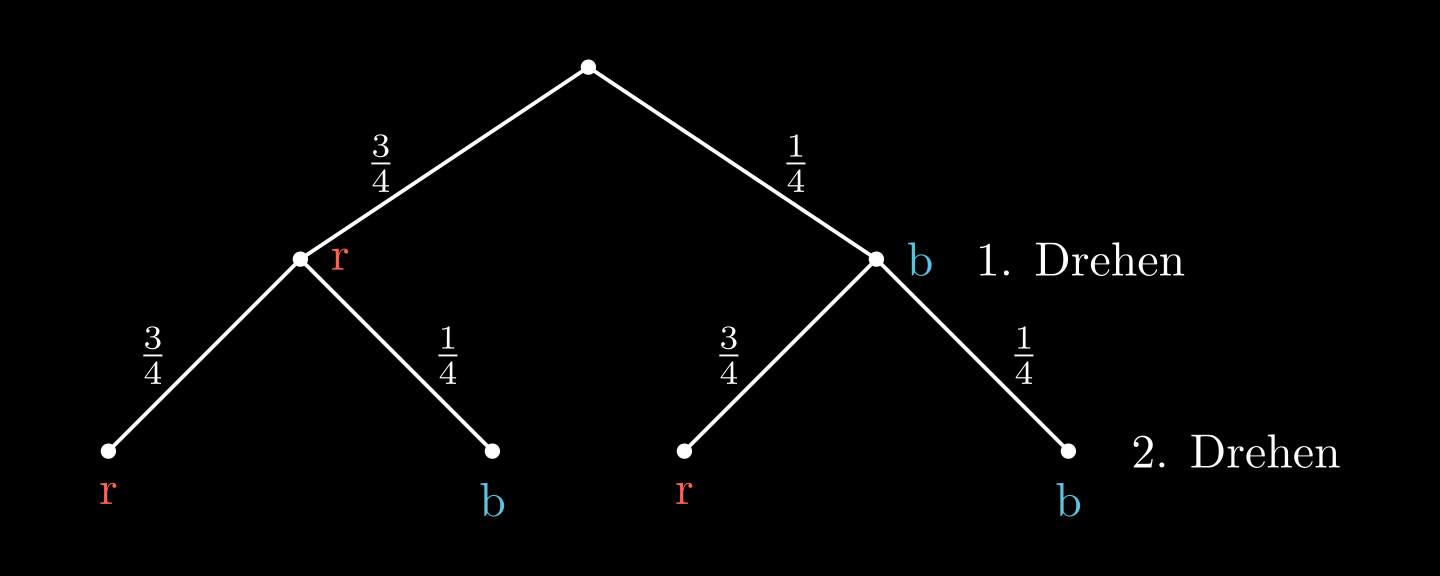

z.B.: „Das Glücksrad wird zweimal Gedreht.“

Ergebnis

z.B.: „zuerst Rot, dann Blau“

Ergebnismenge

Baumdiagramm

Ereignis

z.B.: „mindestens einmal blau drehen“

Ereignismenge

Gegenereignis

„nie blau drehen“

Produktregel

Summenregel

Zufallsvariable

„Gewinn in €“

kann die Werte annehmen

Wahrscheinlichkeitsverteilung

| Gewinn | | | |

|---|---|---|---|

| | | | |

Erwartungswert von

Varianz

Standardabweichung

Ziehen mit Zurücklegen

Werden aus einer Urne mit verschiedene Kugeln, Stück herausgezogen, nach jedem Zug wieder zurückgelegt und in ihrer Reihenfolge notiert, so kann die Anzahl an verschiedenen Reihenfolgen berechnet werden mit:

Beispiel

Ein Würfel mit Seiten wird mal gewürfelt. Wie viele mögliche Zahlenpaare gibt es?

Lösung:

⇒ Es gibt insgesamt verschiedene Zahlenpaare.

Ziehen ohne Zurücklegen

Werden aus einer Urne mit verschiedenen Kugeln, Stück nacheinander herausgezogen ohne diese zurückzulegen und in ihrer Reihenfolge notiert, so kann die Anzahl an verschiedenen Reihenfolgen berechnet werden mit:

Beispiel

Ein Wettrennen hat 8 Teilnehmer. Für die schnellsten gibt es Preise. Wie viele Möglichkeiten gibt es, die Preise zu vergeben?

Lösung:

⇒ Es gibt verschieden Möglichkeiten die Preise zu vergeben

Ziehen mit einem Griff

Werden aus einer Urne mit verschiedenen Kugeln, Stück mit einem Griff (gleichzeitig) herausgezogen, so kann man die Anzahl verschiedener Möglichkeiten berechnet werden mit:

Taschenrechner:

Spezialfälle

Beispiel

Ein Verein hat Mitglieder. Eine Mannschaft besteht aus Spielern. Wie viele mögliche Mannschaften hat der Verein?

Lösung:

⇒ Der Verein hat mögliche Mannschaften

Ein Trick zum berechnen per Hand ist es, die größten Zahlen aus miteinander zu multiplizieren und durch zu teilen.

In dem Beispiel oben kommt man dadurch schnell auf den letzten Term mit je

Faktoren im Zähler und Nenner. Diese kann man dann oft noch weiter kürzen.

Erwartungswert, Varianz und Standardabweichung

Für eine Zufallsvariable , die die Werte annehmen kann, definiert man den Erwartungswert von als:

gibt an, welcher Wert für im Durchschnitt auf lange Sicht zu erwarten ist.

Ein Spiel heißt fair, wenn der Gewinn = 0 ist.

Die Varianz

und die Standardabweichung

sind Maße für die durchschnittliche Abweichung von zum Erwartungswert.

Beispiel

siehe Grundbegriffe der Wahrscheinlichkeitsrechnung

Bedingte Wahrscheinlichkeit

Für zwei Ereignisse und mit ist die bedingte Wahrscheinlichkeit, die Wahrscheinlichkeit für das Eintreten von unter der Bedingung, dass schon eingetreten ist.

Beispiel

U: „Einkauf ist unter 10€.“ K: „Einkauf wird mit Karte bezahlt.“

Stochastische Unabhängigkeit

Definition

Zwei Ereignisse und heißen stochastisch unabhängig, wenn:

Satz

Zwei Ereignisse und sind genau dann stochastisch unabhängig, wenn:

Denn:

Beispiel

In einem Betrieb hat 570 Mitarbeiter. Davon fahren mit einem Pkw zur Arbeit. Von den 190 auswärtigen Mitarbeitern kommen 177 mit einem Pkw. Untersuche

F: „Fährt mit einem Pkw“ und A: „Kommt von Auswärts“

auf stochastische Unabhängigkeit.

Bernoulli-Experiment und Bernoulli-Kette

Ein Zufallsversuch mit genau zwei möglichen Ergebnissen heißt Bernoulli-Experiment.

Wenn man ein Bernoulli-Experiment -mal wiederholt, sodass die Durchführungen voneinander unabhängig sind, so spricht man von einer Bernoulli-Kette der Länge .

Beispiel

5-mal eine Münze werfen ist eine Bernoulli-Kette der Länge 5, da es genau zwei Ergebnisse gibt (Kopf oder Zahl) und ein einzelner Münzwurf keinen Einfluss auf die anderen Münzwürfe hat.

Die Formel von Bernoulli

Für eine Bernoulli-Kette der Länge und Trefferwahrscheinlichkeit gilt für die Anzahl an Treffern :

Man schreibt auch und sagt ist binomialverteilt.

Für den Erwartungswert gilt:

Beispiel

10-facher Münzwurf

genau 5 mal Zahl

höchstens 5 mal Zahl

Umformungen

Standardabweichung einer Binomialverteilung

ist eine binomialverteilte Zufallsgröße.

Beispiel

Zweiseitiger Hypothesentest

Beispiel

Es soll eine Münze überprüft werden:

Nullhypothese (Münze ist in Ordnung)

Gegenhypothese (Alternative) (Münze ist verbogen)

Signifikanzniveau (maximale Irrtumswahrscheinlichkeit)

Gesuchte Grenzen und :

soll dabei möglichst groß und möglichst klein sein.

Tabellenkalkulation

Linksseitiger Test:

ist die größtmögliche Zahl mit .

| | | |

|---|---|---|

| | | kleiner als |

| | | größer als |

⇒

Rechtsseitiger Test:

ist die kleinstmöglichste Zahl mit

bzw. die kleinstmöglichste Zahl mit

| | | |

|---|---|---|

| | | kleiner als |

| | | größer als |

⇒

Ablehnungsbereich der Nullhypothese: {0; 1; …; 17} und {33; …; 50}

Die Nullhypothese wird verworfen, wenn maximal 17 oder mindestens 33 mal Kopf geworfen wird (Münze ist verbogen).

Annahmebereich der Nullhypothese: {18; …; 32}

Die Nullhypothese wird angenommen, wenn mindestens 18 und höchstens 32 mal Kopf geworfen wird (Münze ist in Ordnung).

Irrtumswahrscheinlichkeit:

Die Wahrscheinlichkeit, dass die man denkt, dass die Münze verbogen ist, obwohl sie in Ordnung ist. Sie beträgt:

Einseitiger Hypothesentest

Stichprobenumfang und Signifikanzniveau werden festgelegt.

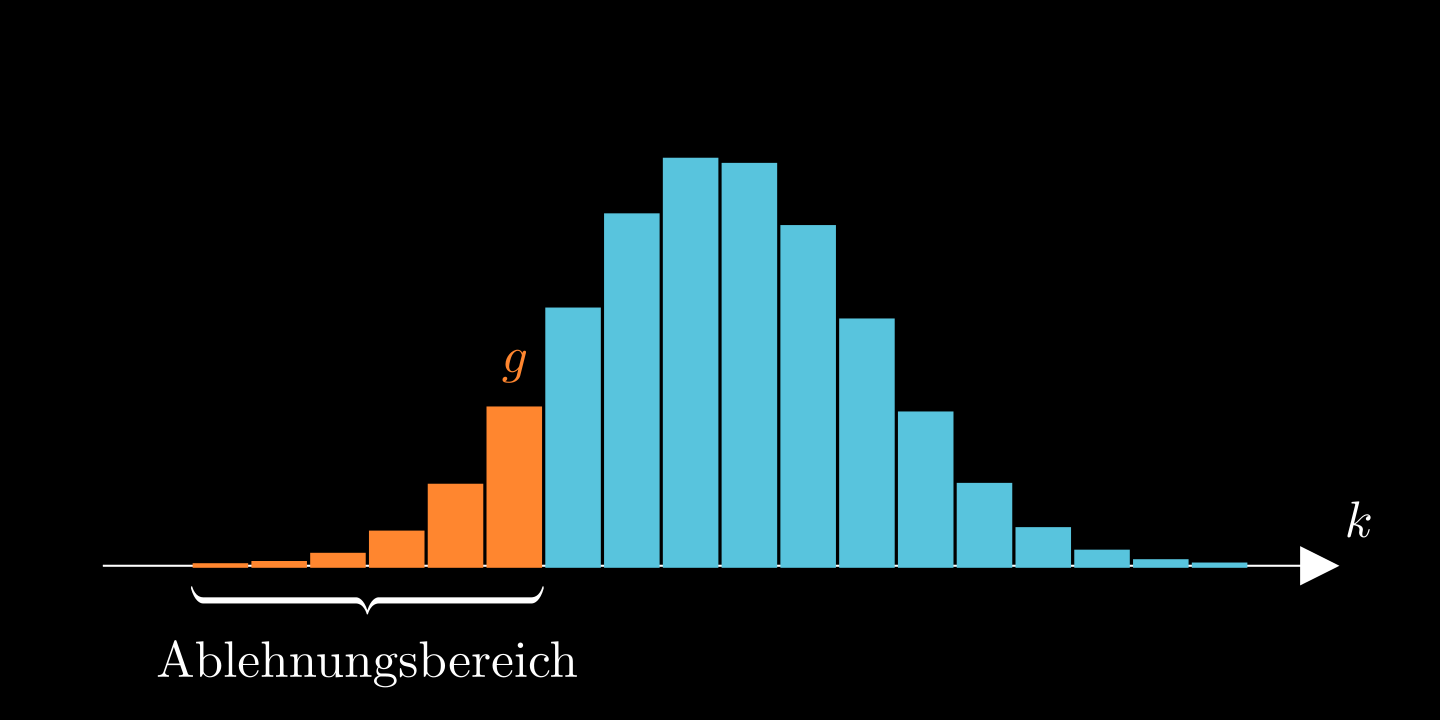

Linksseitiger Test

Nullhypothese:

Gegenhypothese:

Ablehnungsbereich: , wobei die größte Natürliche Zahl mit

ist.

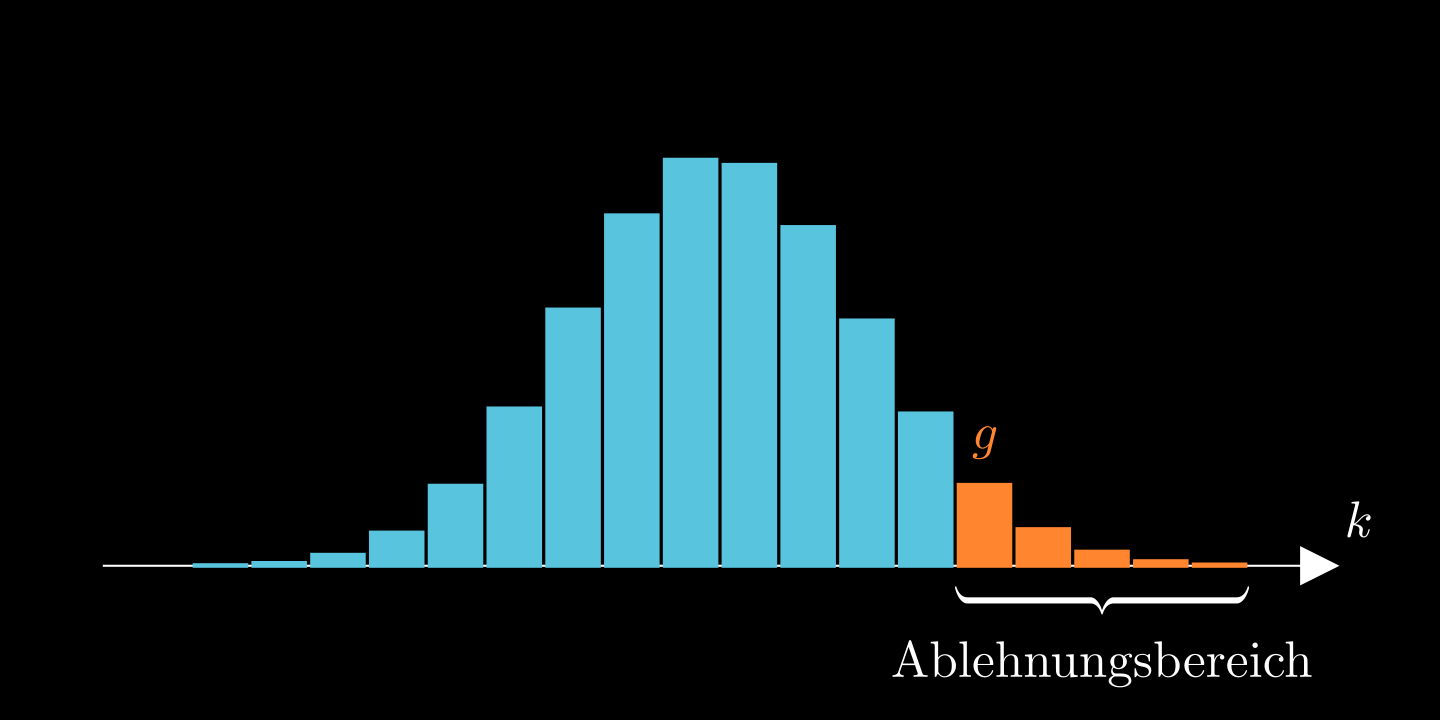

Rechtsseitiger Test

Nullhypothese:

Gegenhypothese:

Ablehnungsbereich: , wobei die kleinste natürliche Zahl mit

ist.

Man führt eine Stichprobe vom Umfang durch.

Entscheidungsregel:

Wenn das Stichprobenergebnis im Ablehnungsbereich liegt, wird verworfen. Ansonsten wird angenommen.

Fehler 1. und 2. Art

| ist wahr | ist falsch | |

|---|---|---|

| wird verworfen | Fehler 1. Art | |

| wird nicht verworfen | | Fehler 2.Art |

- Die Wahrscheinlichkeit für den Fehler 1. Art ist die Irrtumswahrscheinlichkeit

- Die Wahrscheinlichkeit für den Fehler 2. Art ist und lässt sich nur berechnen, wenn die echte Trefferwahrscheinlichkeit gegeben ist

- Wenn man vergrößert und beibehält, so wird kleiner

- Wenn man beibehält und verkleinert, so wird größer

- kann verkleinert werden, indem man verkleinert

- kann verkleinert werden, indem man vergrößert

In anderen Worten:

Der Fehler 1. Art ist, wenn man im Ablehnungsbereich landet, obwohl die Nullhypothese wahr ist.

Der Fehler 2. Art ist, wenn man nicht im Ablehnungsbereich landet, obwohl die Nullhypothese falsch ist.

Beispiel

Angenommen, eine Firma testet, ob eine neue Batterie eine durchschnittliche Laufzeit von mindestens 10 Stunden hat.

: Die Batterie hält weniger als 10 Stunden.

: Die Batterie hält mindestens 10 Stunden.

Fehler 1. Art

Der Test ergibt, dass die Laufzeit mindestens 10 Stunden beträgt ( wird verworfen), obwohl sie in Wirklichkeit weniger als 10 Stunden beträgt ( ist wahr).

→ Die Firma akzeptiert schlechte Batterien.

Fehler 2.Art

Der Test ergibt, dass die Laufzeit weniger als 10 Stunden beträgt ( wird angenommen), obwohl sie in Wirklichkeit mindestens 10 Stunden beträgt ( ist falsch).

→ Die Firma wirft gute Batterien weg.

Berechnen von und

Wahl der Nullhypothese

Bei einem Hypothesentest wird der Fehler, dass die Nullhypothese aufgrund des Stichprobenergebnisses fälschlicherweise verworfen wird, kontrolliert

Seine Wahrscheinlichkeit ist stets höchstens so groß wie das Signifikanzniveau .

1. Faustregel

Man wählt die Nullhypothese so, dass der Fehler 1. Art derjenige ist, den man vermeiden möchte.

2. Faustregel

Man wählt die Behauptung, die statistisch gestützt werden soll, als Alternative.

Beispiel

Eine Zeitung behauptet, dass sich maximal 85% der Autofahrer angurten. Ein Autoclub bezweifelt dies.

Aus der 2. Faustregel folgt:

Der Autoclub möchte zeigen, dass sich mehr als 85% angurten. Daher wählt man

. Daraus folgt .

Dadurch ist die 1. Faustregel auch erfüllt:

- Der Fehler 1. Art ist, dass sich in Wahrheit weniger als 85% angurten, der Autoclub allerdings denkt, dass es mehr als 85% sind.

- Der Fehler 2. Art ist, dass sich in Wahrheit mehr als 85% angurten, der Autoclub allerdings denkt, dass es weniger als 85% sind.

Der schlimmere Fehler ist der 1. Art, da der Autoclub der Zeitung vorwirft falsche Informationen zu verbreiten. Beim Fehler 2. Art würde im schlimmsten Fall unnötigerweise eine Kampagne zur Förderung des Anschnallens gestartet werden.

Die 1. Faustregel folgt meist aus der 2. Faustregel. Daher ist es oft am einfachsten, nach der 2. Faustregel zu handeln, da diese auch einfacher ist und man nicht argumentieren muss, welcher Fehler schlimmer ist.

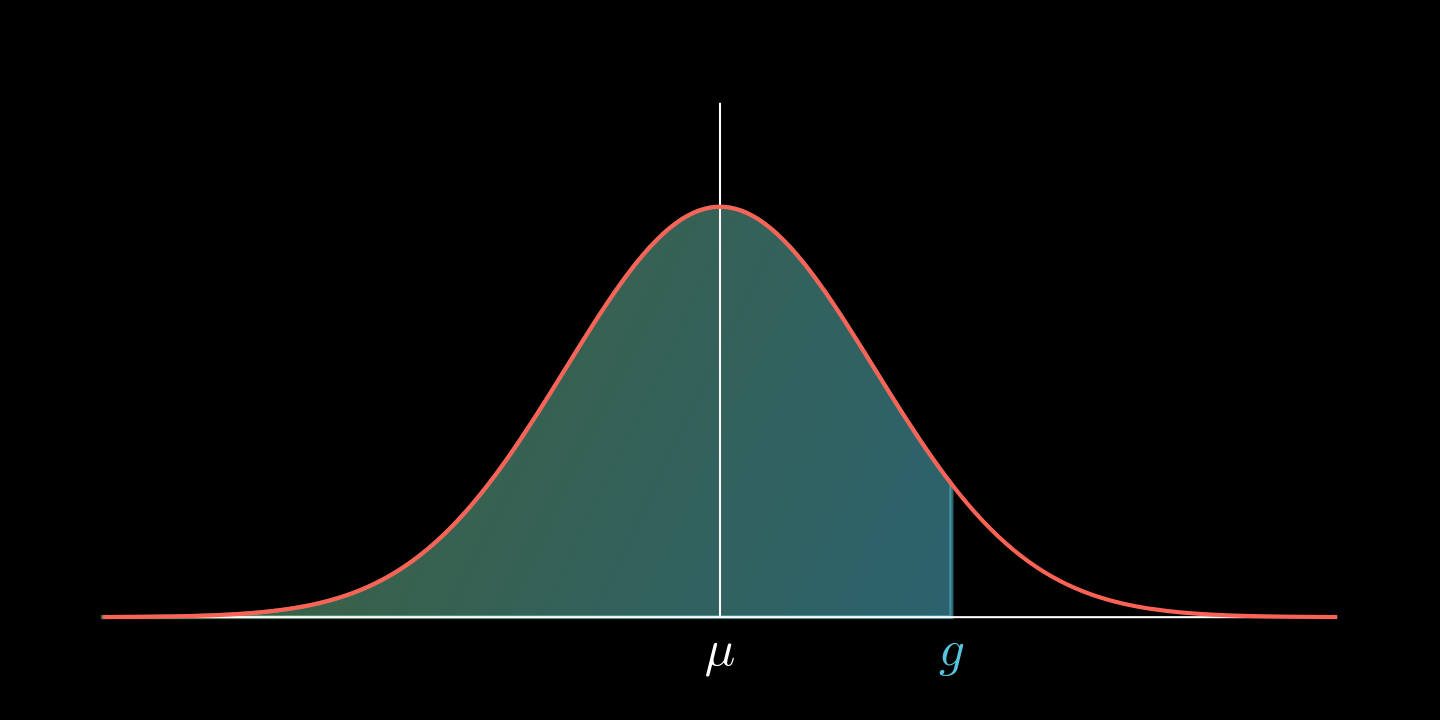

Normalverteilung und Gaußsche Glockenfunktion

Eine Zufallsgröße heißt normalverteilt mit den Parametern (Erwartungswert) und (Standardabweichung), wenn für zwei reellen Zahlen und mit gilt:

Die Wahrscheinlichkeit, dass

Werte zwischen und annimmt, ist

Man sagt kurz: ist -verteilt. Die Normalverteilung ist eine stetige Verteilung.

Man nennt die Funktion mit

Gaußsche Glockenfunktion und ihren Graphen Gaußsche Glockenkurve.

hat die Extremstelle und die Wendestellen und ist die Dichtefunktion einer -verteilten Zufallsgröße.

Es gilt

Zusätzlich gilt:

Beispiele

und aus gegebenen Daten ermitteln

Gemessene Daten können häufig durch eine Normalverteilung mit Mittelwert und Standardabweichung modelliert werden.

Für die Messwerte

gilt:

Beispiel

Punkte in der nächsten Mathe Klausur:

| Messwerte: | 11 | 13 | 15 | 12 | 14 | 12 |

|---|

⇒ Die Messwerte können durch eine -verteilte Zufallsgröße modelliert werden.

Umkehrung der Normalverteilung

Für eine -verteilte Zufallsgröße lässt sich für eine vorgegebene Wahrscheinlichkeit durch den WTR-Befehl invNormal die Zahl mit bestimmen.

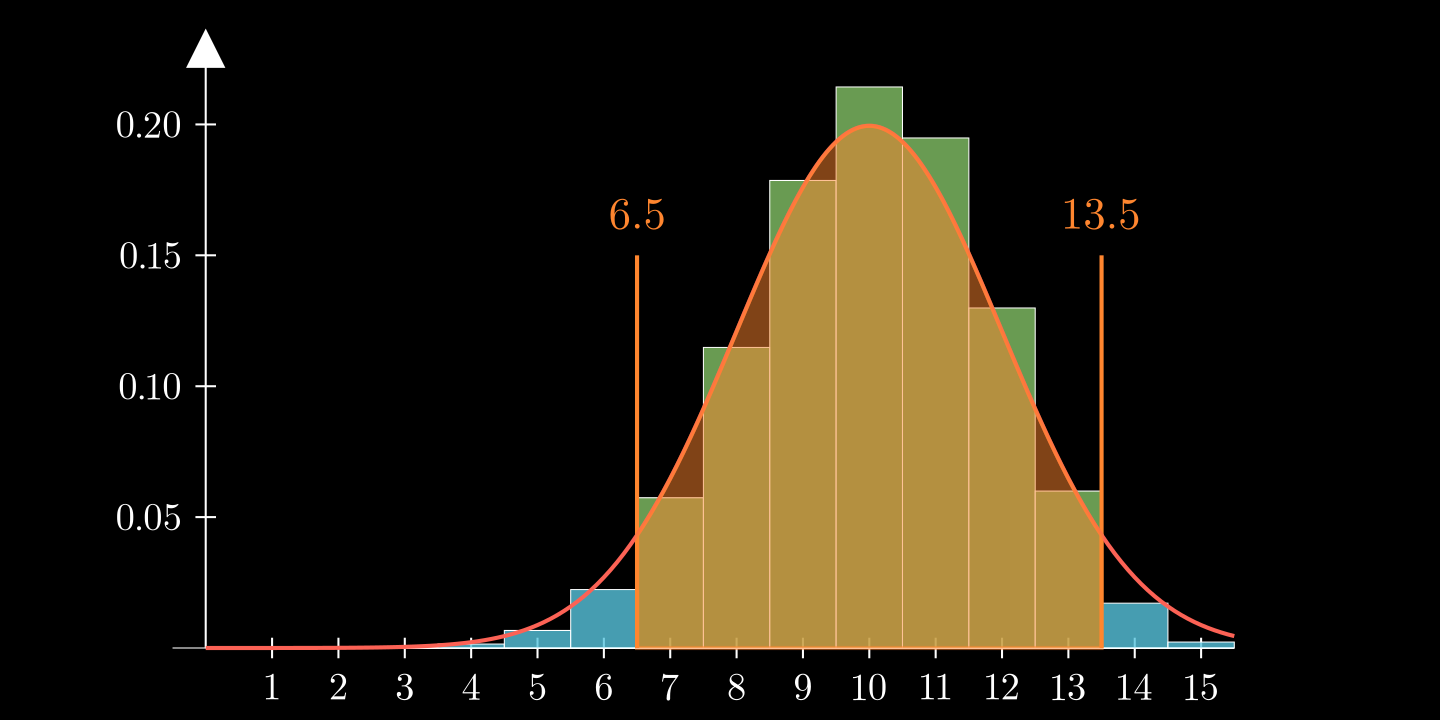

Normalverteilung zur Annäherung einer diskreten Zufallsgröße

Nutzt man die Normalverteilung um die Wahrscheinlichkeit für eine diskrete Zufallsgröße näherungsweise zu bestimmen, muss man die Integralgrenzen entsprechend anpassen.

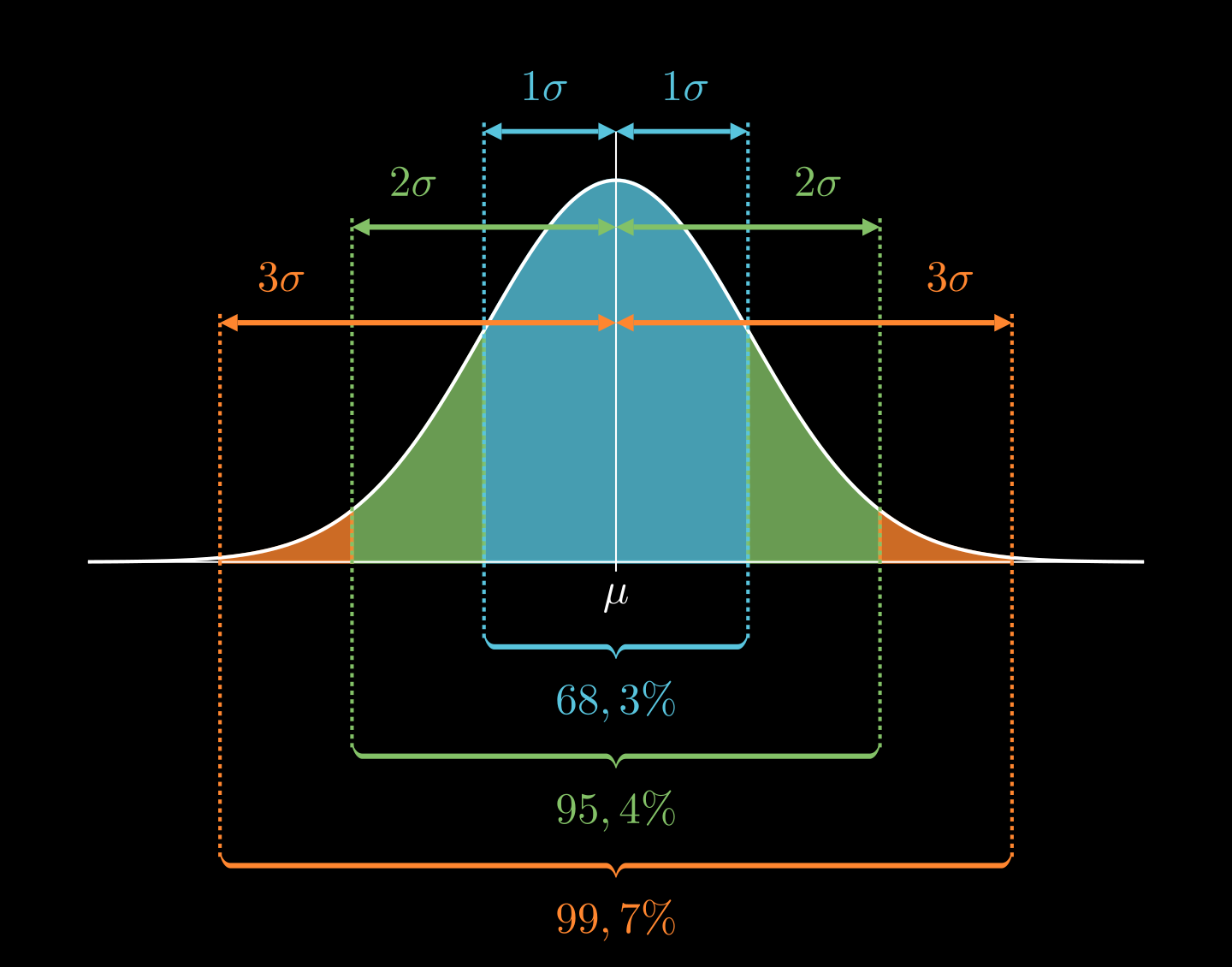

Sigma-Regeln